Agentic AI Foundation: standard aperti per far cooperare davvero gli agenti

Il settore sta uscendo dalla fase “chat” e entrando in quella “agentica”: software che agiscono sul web, trattano con altri agenti, eseguono compiti end‑to‑end. OpenAI, Anthropic e Block hanno annunciato la Agentic AI Foundation (AAIF) sotto l’ombrello della Linux Foundation per spingere standard aperti e governance neutrale. In dote arrivano tre asset chiave: MCP (Model Context Protocol) di Anthropic, Agents.md di OpenAI e Goose di Block, tutti trasferiti alla fondazione per una crescita a contributo aperto. Tra i sostenitori figurano anche Google, Microsoft, AWS, Bloomberg e Cloudflare.

Perché gli standard servono davvero (adesso)

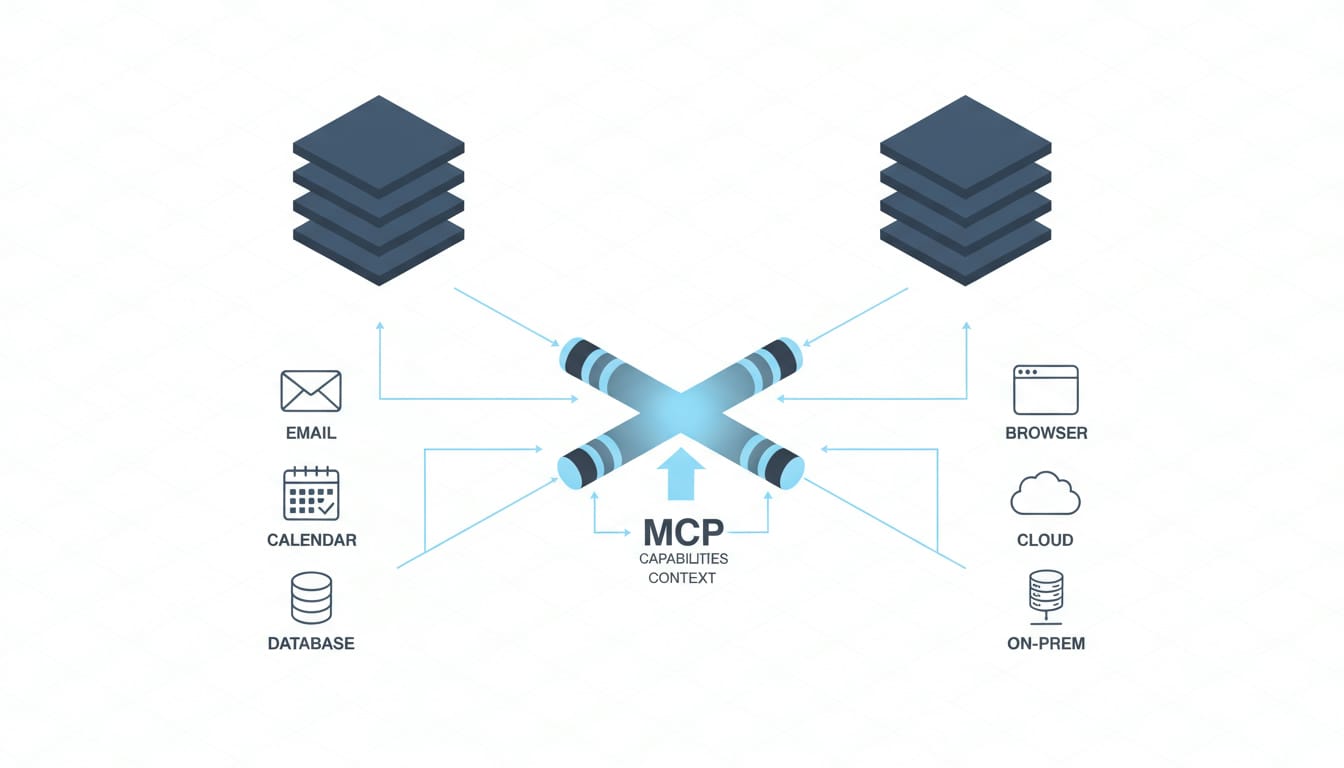

Se vogliamo agenti che prenotano viaggi, negoziano prezzi o aggiornano ERP senza integrazioni ad hoc, ci servono protocolli comuni: scambio di contesto, definizione delle regole di comportamento, modalità sicure per usare strumenti esterni. È il ruolo che AAIF vuole giocare con MCP, Agents.md e Goose: interoperabilità tra provider e tooling condiviso, senza imporre un modello o un cloud specifico.

MCP oggi è già usato in produzione da varie aziende e, come sottolineato dagli sponsor, la sua apertura può diventare il “bus” comune tra ecosistemi: agenti che parlano tra loro, attraversano domini applicativi e passano di mano tra fornitori diversi. In parallelo, Goose abilita l’esecuzione di azioni sul computer sfruttando più LLM, mentre Agents.md ambisce a codificare—vicino al codice—le regole di ingaggio di un agente.

“Portare questi progetti sotto l’AAIF garantisce che possano crescere con la trasparenza e la stabilità che solo una governance aperta può fornire.” — Jim Zemlin, Linux Foundation

MCP, Agents.md, Goose: cosa significano per chi sviluppa

Ecco come li vedo posizionati nel ciclo di sviluppo, con alcune implicazioni pratiche.

- MCP: canale standard per annunciare capacità (tool, risorse), gestire autenticazione e orchestrare scambi di contesto. Impatto: minore lock‑in, integrazioni più veloci, audit più pulito.

- Agents.md: documento vicino al repository che descrive policy, permessi, tool consentiti e limiti operativi. Impatto: governance‑as‑code, revisione PR trasparente, compliance tracciabile.

- Goose: runtime/SDK per costruire agenti che compiono azioni reali su un host o in cloud, astratti dal singolo LLM. Impatto: testabilità locale, fallback tra modelli, migliori SLO.

Esempio indicativo di un Agents.md minimale, utile per allineare team legale, sicurezza e sviluppo (formato a scopo illustrativo):

# Agent Policies

name: "CheckoutAssistant"

owner: payments-platform

permissions:

read: ["orders", "inventory", "calendar"]

write: ["orders", "calendar"]

tools:

- http

- browser

- payments.create_intent

safety_guardrails:

- "non confermare pagamenti > 200€ senza esplicito consenso utente"

- "mai inviare dati PII a domini non in allowlist"

routing:

mcp_endpoint: "wss://mcp.internal.example"

fallback_models: ["providerA/model-x", "providerB/model-y"]

observability:

trace: open-telemetry

redact: ["card_number", "ssn"]

E un payload MCP semplificato per annunciare tool e risorse disponibili (anche qui, solo a scopo illustrativo):

{

"mcp_version": "1.0",

"capabilities": {

"tools": [

{"name": "calendar.create", "schema": {"title": "CreateEvent", "type": "object"}},

{"name": "email.send", "schema": {"title": "SendEmail", "type": "object"}}

],

"resources": [

{"uri": "db://crm/contacts", "read": true}

]

},

"auth": {"type": "oauth2", "scopes": ["calendar", "email"]}

}

ROI, adozione enterprise e il nodo della fiducia

Qui si inserisce la partita economica. OpenAI e Anthropic hanno pubblicato report che mostrano risparmi di tempo (OpenAI: 40–60 minuti/giorno su un campione di 9.000 lavoratori; Anthropic: riduzione media da 90 a 18 minuti su 100.000 conversazioni, con caveat). Ma altri studi accademici segnalano ROI spesso nullo e “workslop” che non sposta il valore. La verità operativa che vedo nei team è: senza standard e governance chiari, i costi di integrazione e controllo superano i benefici.

Standard aperti aiutano proprio qui: riducono accoppiamento con un singolo vendor, permettono auditing e observability coerenti, e sbloccano riuso tra progetti. Non obbligano a usare i modelli dei fondatori e, allo stesso tempo, permettono a chi fornisce piattaforme (anche OpenAI, Anthropic, Block) di competere su implementazioni, non su lock‑in.

Cloud, infrastruttura e… domotica

Con MCP e co., immagino scenari dove un agente di manutenzione domestica può dialogare con un assistente commerciale in cloud e con un gateway locale Zigbee per prenotare un intervento e ottimizzare i consumi. Il punto critico: identità e permessi coerenti tra edge e cloud, più rate limiting e sandbox dei tool.

Goose è interessante proprio perché esegue azioni concrete su un host (o container). In un flusso IoT puoi far validare un preventivo da un agente finanziario e, solo dopo approvazione, far eseguire a Goose la riconfigurazione del sistema domestico, mantenendo control plane e audit sul lato infrastruttura.

Trade‑off e rischi reali

- Sicurezza: tool potenti moltiplicano la superficie d’attacco. Serve policy‑as‑code, firma dei tool, isolamento per namespace.

- Neutralità vs influenza: standard “aperti” dominanti possono comunque spostare il baricentro verso chi li guida (come ICANN/W3C nel web).

- Compatibilità: versioning rigoroso di protocolli e migrazioni prevedibili sono fondamentali per SLO enterprise.

- Osservabilità: tracing cross‑agent e redazione PII di default, altrimenti la compliance salta.

Checklist operativa (prossime 4–6 settimane)

- Mappare i casi d’uso agentici con impatto reale su KPI (non demo): 1–2 flussi massimo.

- Definire un Agents.md di prova nel repository, con permessi minimi e guardrail espliciti.

- Pilotare MCP in un ambiente di staging: handshake, auth (OAuth2), catalogo tool.

- Valutare Goose per l’esecuzione locale/container con logging firmato e OTEL.

- Stabilire metriche: tempo end‑to‑end, tasso di intervento umano, errori per tool, costo per task.

Stiamo entrando nella fase in cui gli agenti devono coesistere, non solo esibirsi. Standard e governance aperta sono ciò che, storicamente, ha fatto scalare il web. È un buon segnale vederli arrivare anche qui.