Disney x OpenAI: Sora ottiene i personaggi. Per noi builder, la vera partita è governance e guardrail

Walt Disney investirà 1 miliardo di dollari in OpenAI e, nell’ambito di un accordo triennale di licensing, permetterà a Sora di generare brevi video con oltre 200 personaggi Disney, Marvel, Pixar e Star Wars. L’intesa non copre le somiglianze o le voci dei talent, dettaglio non marginale. Alcuni video creati dagli utenti saranno selezionati per lo streaming su Disney+, mentre Disney adotterà le API di OpenAI per nuovi prodotti e strumenti, oltre a distribuire ChatGPT ai propri dipendenti.

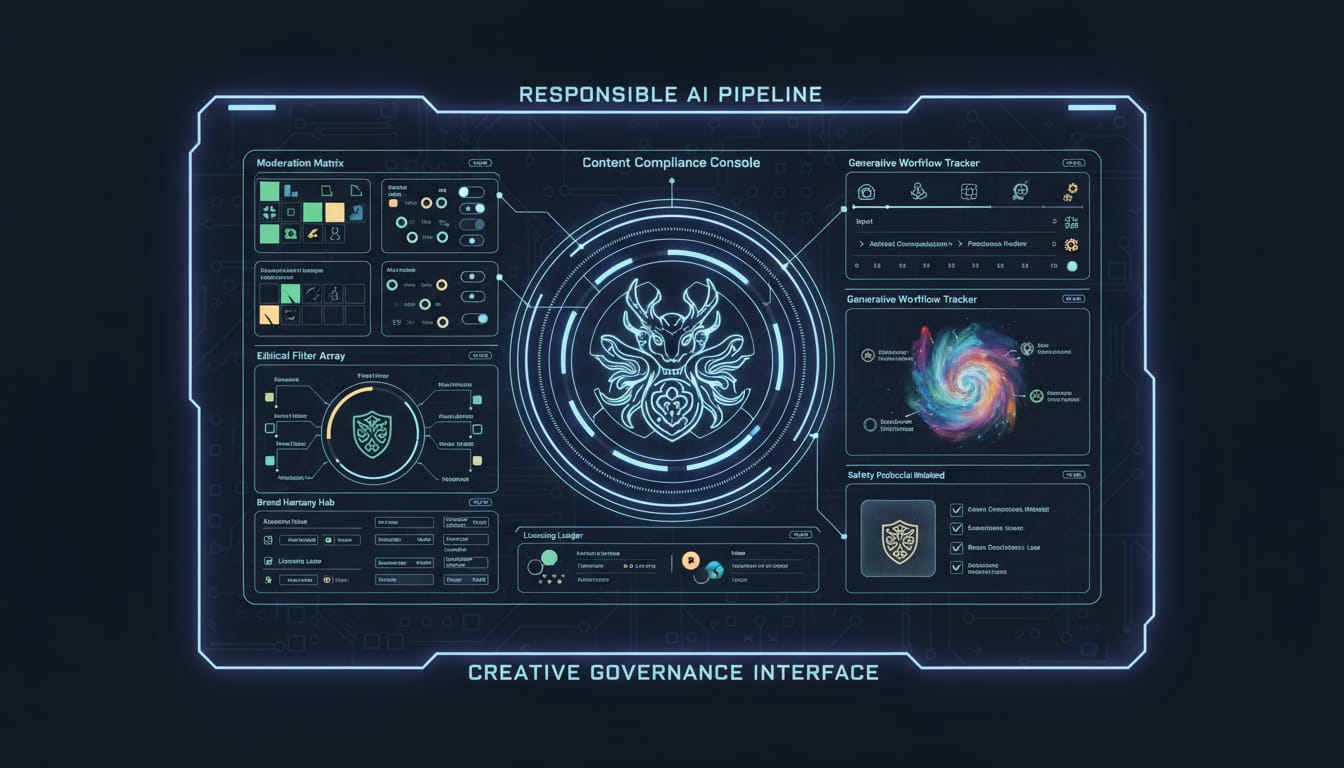

È un passaggio storico perché sposta la conversazione dall’uso “selvaggio” dell’AI generativa alla collaborazione regolata fra detentori di IP e piattaforme. Per noi che costruiamo sistemi AI, la novità non è solo contenutistica: è architetturale. Dovremo progettare pipeline capaci di far convivere creatività, brand safety e compliance.

“L’avanzamento dell’AI è un momento importante per la nostra industria e, attraverso questa collaborazione, estenderemo responsabilmente la portata del nostro storytelling, rispettando e proteggendo creatori e opere.” — Bob Iger

Il contesto spiega bene la posta in gioco: sin dal lancio di Sora abbiamo visto abusi (personaggi noti in contesti inappropriati) e contenziosi sul copyright. Disney stessa ha inviato diffide a piattaforme che sfruttavano senza autorizzazione le sue IP. Questo accordo crea un perimetro chiaro e, soprattutto, trasferisce responsabilità operative su filtri, policy e tracciabilità.

Cosa significa in pratica per chi sviluppa

Se integriamo un modello video come Sora in un prodotto con IP licenziate, servono almeno quattro livelli tecnici:

1) Policy e consent registry. Mappare entità “personaggio” a condizioni d’uso (consentito/negato, contesti ammessi, divieti: violenza, politica, hate symbols). L’accordo esclude voci e somiglianze dei talent: ciò implica blocchi su voice cloning e su prompt che mirano a “suonare come [attore]”.

2) Moderazione multilivello. Non basta filtrare il prompt; serve validare l’output. Un approccio robusto prevede classificatori a cascata (NSFW, violenza, odio, segni politici), più un ciclo di rigenerazione guidata. Per i personaggi noti la tolleranza d’errore va a zero: meglio rifiutare che pubblicare contenuti borderline.

3) Provenienza e audit. Watermarking/provenance (es. standard C2PA) per attestare origine, parametri chiave e catena di trasformazioni. Log immutabili per audit e dispute: chi ha generato cosa, con quali prompt, quali filtri sono intervenuti.

4) Controllo dei canali e curazione. Se alcuni video passeranno su Disney+, è verosimile una coda di revisione umana assistita da modelli, con criteri editoriali e brand safety più stretti della semplice pubblicazione “social”. Devono esistere pathway distinti: generazione personale, condivisione social, invio a curazione/publishing.

“Questo accordo mostra come AI e creativi possano collaborare responsabilmente per promuovere innovazione, rispettare la creatività e raggiungere nuove audience.” — Sam Altman

Trade-off tecnici (oltre l’hype)

- Creatività vs coerenza: per mantenere riconoscibilità del personaggio senza sforare i paletti, può servire una “character bible” consultata in retrieval per descrizioni visive coerenti. Non è fine-tuning indiscriminato: è governance sui contenuti generati.

- Latency vs costi: filtri in cascata e rigenerazioni aumentano i tempi e il costo GPU. La UX deve comunicare chiaramente gli step (pre-check, generazione, validazione) e offrire feedback utili per correzioni rapide del prompt.

- Apertura vs protezione del brand: più libertà aumenta la distanza creativa, ma anche il rischio. Feature flag granulari per aree geografiche, fasce d’età e contesti (marketing interno, UGC, publishing premium) aiutano a calibrare.

Esempio minimale di policy enforcement

// Pseudocodice TypeScript per blocchi di policy su personaggi licenziati

const PROHIBITED_CONTEXT = ["odio", "nazismo", "politica", "violenza esplicita"];

const LICENSED_SET = new Set(["disney", "marvel", "pixar", "star-wars"]);

function validateRequest(req: {

characterPack?: string; // es. "marvel"

prompt: string;

ttsVoice?: string; // eventuale voce richiesta

}): { allowed: boolean; reason?: string } {

if (req.characterPack && !LICENSED_SET.has(req.characterPack)) {

return { allowed: false, reason: "Pacchetto personaggi non autorizzato" };

}

if (PROHIBITED_CONTEXT.some(k => req.prompt.toLowerCase().includes(k))) {

return { allowed: false, reason: "Contesto non consentito per personaggi IP" };

}

if (req.ttsVoice && /sounds like .*? (attore|attrice|celebrity)/i.test(req.ttsVoice)) {

return { allowed: false, reason: "Somiglianza vocale di talent esclusa dal licensing" };

}

return { allowed: true };

}

Implicazioni organizzative

L’accordo mostra anche il rovescio della medaglia: se vuoi che l’AI entri nel catalogo e nei workflow core, devi investire in tooling, policy, training delle persone e processi di escalation. Disney adotterà le API di OpenAI e ChatGPT internamente: tipico segnale che si punta a integrare assistenti e generazione nei flussi reali (localizzazione, adattamento creativo, asset management), non solo in demo.

Ultimo punto, spesso sottovalutato: trasparenza con i creativi. Le esclusioni sulle voci e sulle somiglianze dei talent rispondono a preoccupazioni legittime dell’industria. Se costruiamo strumenti su IP altrui, la comunicazione delle policy e dei confini non è un dettaglio: è parte del prodotto.

Per chi sviluppa, l’occasione è chiara: passare da prototipi “tutto è possibile” a piattaforme governate dove AI, licensing e responsabilità coesistono. La tecnologia è matura abbastanza; ora tocca a noi progettare i guardrail giusti.