Agenti di ricerca profondi: la mossa di Google nel giorno di GPT‑5.2

Il tempismo, a volte, è tutto. Google ha presentato una versione “reimmaginata” del suo agente di deep research basato su Gemini 3 Pro proprio mentre OpenAI ha rilasciato GPT‑5.2 (nome in codice “Garlic”). Due mosse nello stesso giorno che raccontano bene dove sta andando l’AI: meno prompt isolati, più agenti che cercano, leggono, incrociano fonti e producono report affidabili.

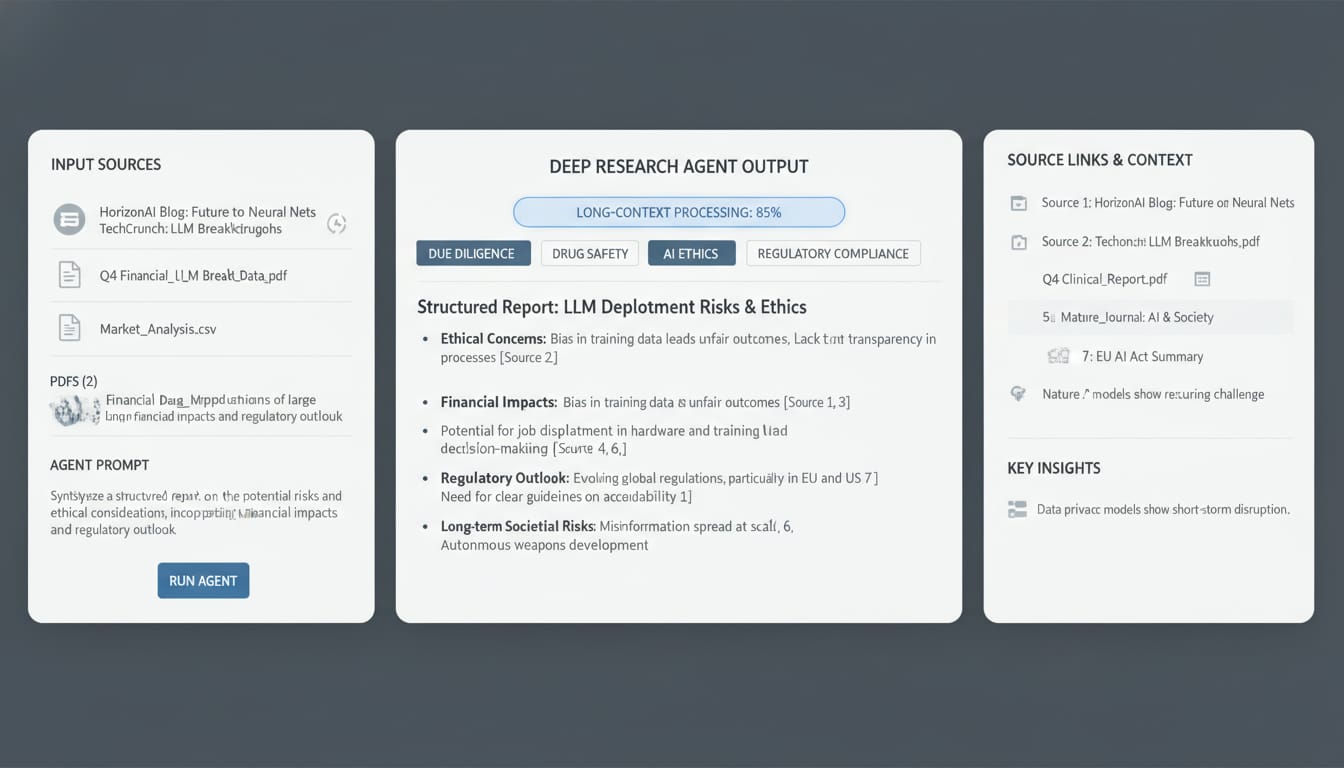

Secondo Google, l’agente di ricerca profonda è pensato per sintetizzare “montagne di informazioni”, gestire contesti lunghi nel prompt e ridurre le allucinazioni grazie al modello più “factual” della casa (Gemini 3 Pro). Non è solo per scrivere report: l’idea è permettere agli sviluppatori di incorporare queste capacità nelle proprie app tramite una nuova interfaccia orientata al controllo degli agenti. I casi d’uso citati vanno dalla due diligence alla valutazione della tossicità dei farmaci. Google ha anche dichiarato che integrerà l’agente in Search, Finance, nell’app Gemini e in NotebookLM: un passo verso un mondo in cui non “cerchiamo” più, ma delegiamo il lavoro a un assistente.

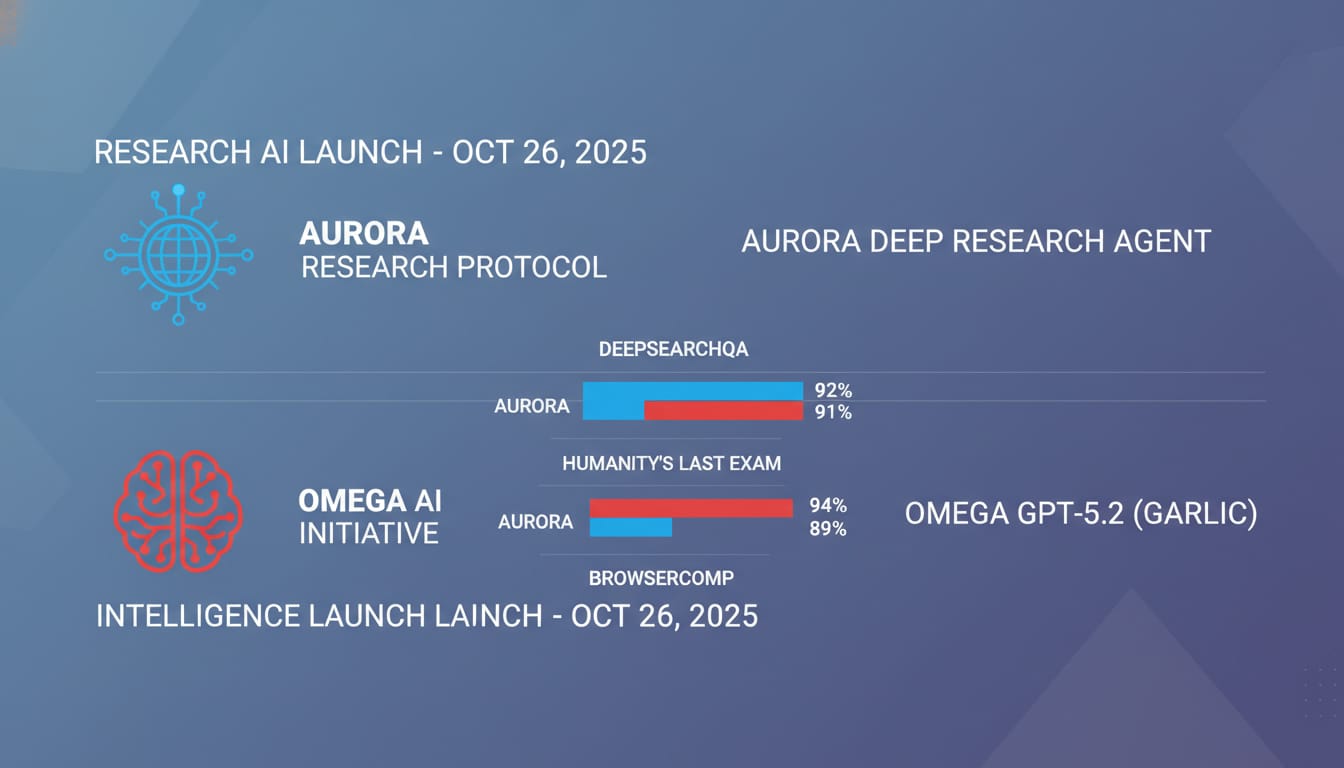

Per misurare i progressi, Google ha pubblicato un nuovo benchmark open source, DeepSearchQA, orientato ai compiti multi-step di ricerca informativa. Ha inoltre testato l’agente su Humanity’s Last Exam e su BrowserComp (quest’ultimo per compiti agentici basati su browser). Nelle prove comunicate, il nuovo agente risulta primo sul proprio benchmark e su Humanity’s Last Exam, mentre OpenAI (ChatGPT 5 Pro) resta molto vicino e supera Google su BrowserComp. Quasi in simultanea, però, OpenAI ha svelato GPT‑5.2, sostenendo un vantaggio sui soliti benchmark di riferimento.

Tradotto: i numeri di ieri diventano vecchi in ore. Ma per chi costruisce prodotti, la classifica è solo metà storia. L’altra metà è controllo (cosa può fare l’agente, quando, con quali limiti), affidabilità (minimizzare le “cascate di allucinazioni” nei compiti lunghi) e integrazione (strumenti, fonti, audit trail).

Cosa cambia per chi costruisce agenti

Con agenti di ricerca profonda destinati a finire in Search, Finance e blocchi note intelligenti, serve una postura ingegneristica chiara:

- Tracciare le evidenze: ogni affermazione con link alla fonte. Vietare output “non citati” per certe categorie di task.

- Budget e profondità: imporre limiti a tempo, costo e numero di passi. I compiti open‑ended vanno strozzati in obiettivi misurabili.

- Verifica multi‑pass: un secondo agente (o lo stesso in modalità differente) che prova a confutare il risultato prima della consegna.

- Difese sul browsing: prompt‑injection e pagine ostili sono reali. Whitelist di domini, strumenti di sanificazione del DOM e regole di azione.

Nota di contesto: Gartner ha consigliato alle aziende di evitare i browser “AI” per i rischi di sicurezza; il tema vale anche per agenti che navigano autonomamente. Se l’agente può cliccare, serve un recinto di sicurezza.

Un pattern pratico (pseudocodice)

// Ricerca profonda con limiti, citazioni obbligatorie e verifica

const job = deepResearch.createJob({

query: userQuestion,

sources: ["web", "pdf", "sheets"],

maxDepth: 4, // passi agentici

maxTimeMs: 120000, // timeout duro

maxCost: 0.75, // budget

requireCitations: true,

safety: { domainAllowlist: [".gov", ".edu", "trusted.tld"], actions: ["read", "summarize"] },

});

const draft = await job.run();

const checked = await verify.withCounterAgent(draft, { adversarial: true });

if (!checked.hasCitations || checked.risk > 0.3) {

return fallback.simpleQA(userQuestion);

}

return checked;

Questo non richiede una singola API “magica”: è un orchestrator pattern che potete replicare con qualunque modello e stack, da un workflow in n8n a un servizio server‑side, purché abbiate telemetria, limiti e passi di verifica.

Benchmark sì, ma con metriche operative

I benchmark aiutano a orientarsi (DeepSearchQA, Humanity’s Last Exam, BrowserComp), ma nella pratica le metriche che contano sono tassi di citazione valida, tempo per risposta verificata, costo per task e percentuale di fallback. Sono questi numeri che fanno la differenza quando l’agente deve vivere dentro un prodotto, non in un PDF di confronto modelli.

Il messaggio di fondo è semplice: la corsa tra Google e OpenAI è utile, ma la vera leva è spostare il discorso da “quanto è bravo il modello” a “quanto è governabile e tracciabile il comportamento dell’agente dentro il mio dominio”. I progressi sul fronte “factual” e i nuovi benchmark sono incoraggianti; ora tocca a noi ingegnerizzarli con rigore.