Google rende “agent-ready” i suoi servizi: MCP gestito per collegare gli LLM senza colla

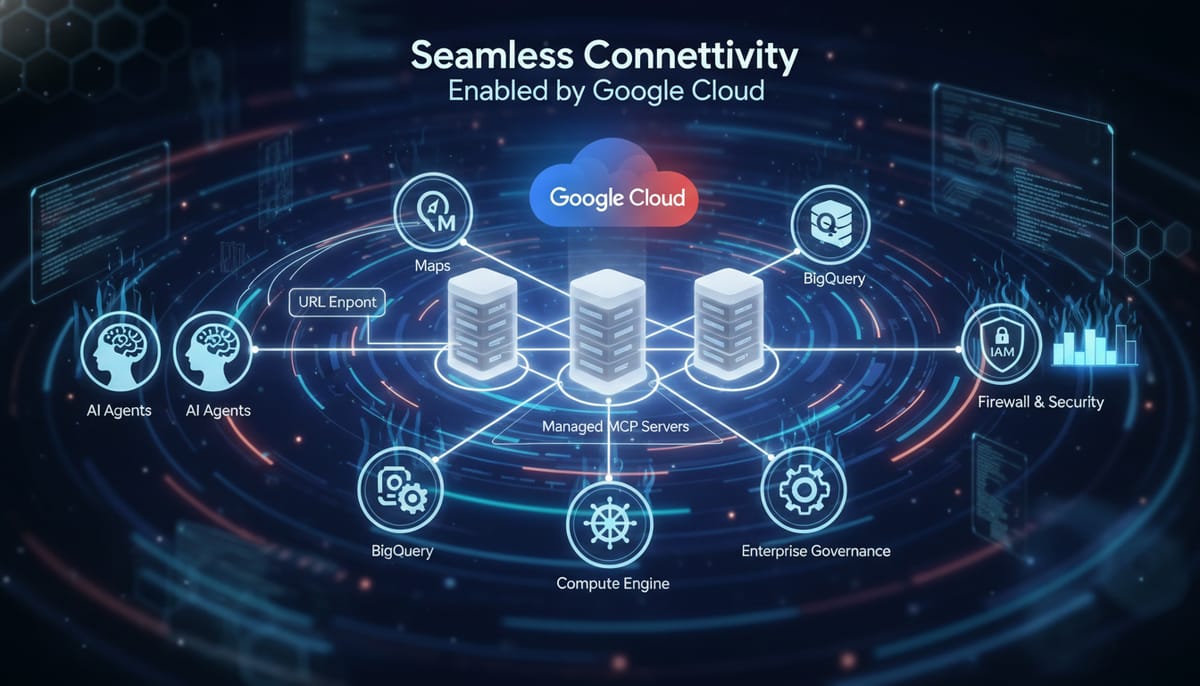

Se costruisci agenti, sai quanto tempo si perde tra connettori, credenziali e pezzi di colla che si rompono quando meno te lo aspetti. Google prova a togliere di mezzo tutto questo introducendo server MCP gestiti: endpoint remoti che espongono strumenti di Google e Google Cloud direttamente agli agenti, senza dover mantenere integrazioni custom. L’idea è semplice: incolli un URL e l’agente trova strumenti pronti e governati.

Cos’è MCP e perché è importante ora

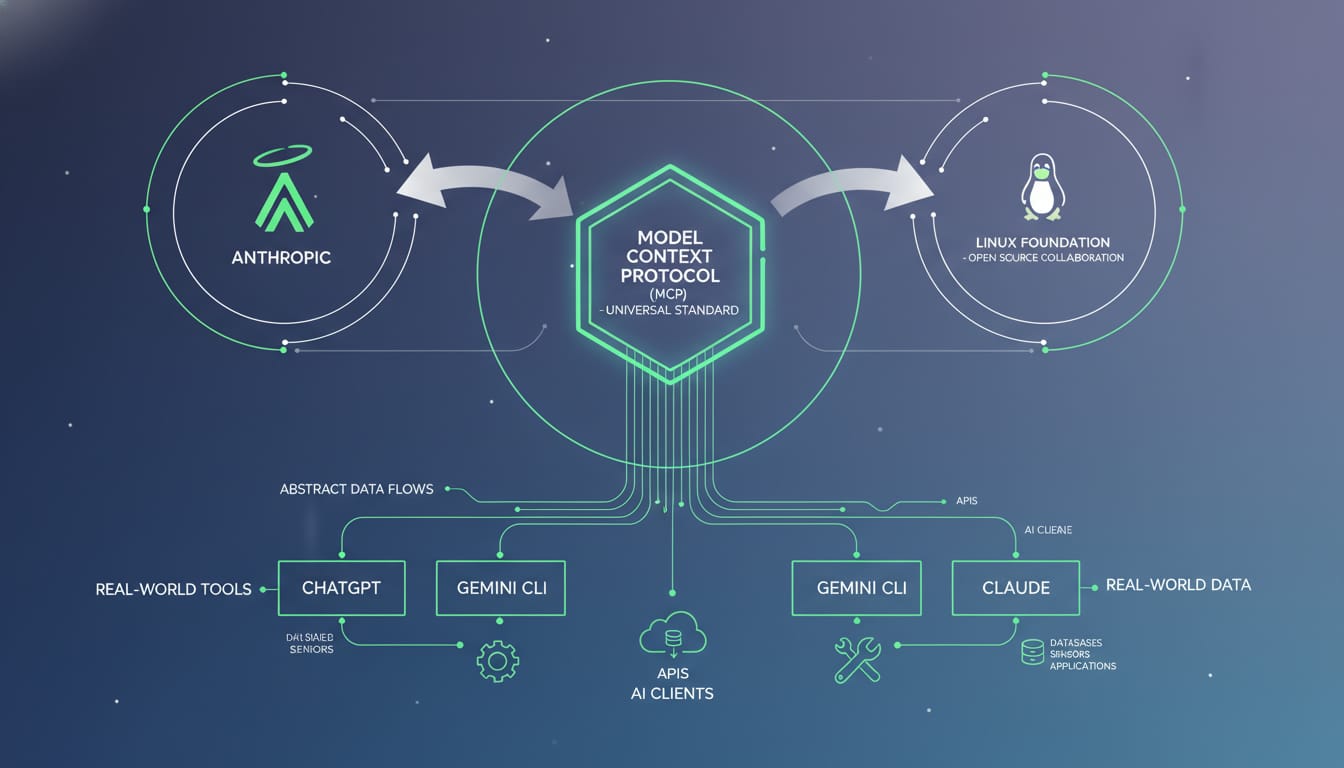

MCP (Model Context Protocol) è uno standard open source nato in Anthropic per collegare modelli e agenti a dati e strumenti reali. La sua adozione è esplosa nell’ecosistema dei tool per agenti; proprio in questi giorni Anthropic ha donato MCP a un fondo della Linux Foundation per accelerarne standardizzazione e apertura. Il valore pratico: se esiste un server MCP, qualunque client compatibile può parlare con lui. Niente SDK proprietari, meno lock-in di integrazione.

Cosa lancia Google

Google introduce server MCP completamente gestiti per i suoi servizi. In partenza: Maps, BigQuery, Compute Engine e Kubernetes Engine. In pratica, un agente analitico può interrogare BigQuery direttamente; un agente ops può intervenire su Compute Engine o GKE; un assistente di viaggio può ancorarsi a dati aggiornati di Maps (non solo “memoria del modello”).

Dal lato client, Google cita Gemini CLI e AI Studio, ma i test interni mostrano che anche Claude e ChatGPT, come client MCP, “funzionano e basta”. Questo è il punto dello standard: stesso server, più client.

Perché interessa a chi costruisce agenti

Il guadagno è nel ciclo di vita: invece di una o due settimane per cablare un connettore, si passa a un endpoint gestito, con strumenti dichiarati e scopribili dall’agente. Meno manutenzione, più prevedibilità e un punto unico di governance. In azienda significa anche allineare i processi di sicurezza esistenti agli agenti, senza creare canali paralleli.

Governance e sicurezza: IAM, Model Armor, audit

I server MCP gestiti sfruttano Google Cloud IAM per esprimere in modo esplicito “che cosa può fare l’agente”. In più, Model Armor funge da firewall per workload agentici, con mitigazioni contro minacce come prompt injection ed esfiltrazione. Tutto è osservabile via audit logging. È l’equivalente dei guardrail usati dalle app tradizionali, applicati agli agenti.

Apigee come ponte tra API e agenti

La mossa più “enterprise” è l’uso di Apigee: se oggi gestisci API (chiavi, quote, monitoraggio), Apigee può “tradurre” un’API standard in un server MCP. Un catalogo prodotti esposto come REST diventa una serie di strumenti che l’agente può scoprire e usare, mantenendo le stesse politiche di sicurezza e controllo.

Stato, costi e roadmap

I server MCP sono in public preview: non ancora coperti pienamente dai termini di servizio Google Cloud, ma offerti senza costi aggiuntivi ai clienti enterprise che già pagano per i servizi Google coinvolti. Google parla di disponibilità generale “presto nel nuovo anno” e di nuovi server in arrivo su base settimanale. Nel mirino i servizi di storage, database, logging/monitoring e sicurezza.

Trade-off reali

Qualche considerazione pragmatica:

- Preview: utile per sperimentare e fare spike, ma occhio alle policy interne e ai carichi di produzione.

- Lock-in operativo: lo standard è aperto, ma il server è gestito da Google; dipendi dalla sua disponibilità, limiti e roadmap.

- Modello di permessi: IAM è potente, però richiede disciplina nella definizione dei ruoli dell’agente per evitare privilegi eccessivi.

- Costi indiretti: i server MCP non costano extra, ma le chiamate ai servizi sottostanti sì; servono quote e budget.

Esempio pragmatico (schematico)

Questo è lo scheletro di come mi aspetto di collegare un client MCP a un endpoint gestito. È pseudocodice, non un SDK reale: l’obiettivo è valorizzare il flusso mentale, non copiare-incollare.

// Pseudocodice: configurazione client MCP verso un endpoint gestito

const client = new MCPClient({

serverUrl: process.env.MCP_SERVER_URL, // es. endpoint gestito Maps/BigQuery

authToken: process.env.MCP_BEARER_TOKEN, // emesso via IAM/Apigee secondo policy

})

// L'agente interroga gli strumenti esposti dal server

const tools = await client.discoverTools() // p.es. bigquery.query, maps.search

// Esegue una chiamata tipizzata

const result = await client.call('bigquery.query', {

sql: 'SELECT city, COUNT(*) FROM visits GROUP BY city ORDER BY 2 DESC LIMIT 5'

})

Contesto più ampio

La direzione è chiara: meno “colla”, più standard, più governance. Non stupisce vedere in parallelo grandi adozioni di piattaforme AI in ambito pubblico: il Dipartimento della Difesa USA ha scelto il sistema Gemini for Government per portare capacità AI a milioni di dipendenti. Non è lo stesso annuncio, ma indica la spinta verso soluzioni gestite e governabili su scala.

In sintesi: i server MCP gestiti di Google colmano il divario tra agenti e strumenti reali con uno strato standardizzato e difendibile. Se stai costruendo agenti per casi d’uso seri, vale la pena pianificare una prova controllata: verificare latenza, permessi minimi efficaci, osservabilità e costi. Poi, quando la GA arriverà, avrai già il percorso di produzione tracciato.